こんにちは、六本木アナリティクスエンジニアのTaku(@aelabdata )です。

データはたくさんあるが、分析結果が信用できない…

新しいレポートを作るのに時間がかかりすぎる…

データ活用の現場で、これらの課題はよく耳にします。

従来のデータ分析プロセスは、データエンジニアリング(システムの構築)とデータ分析(インサイトの抽出)の間が分断され、場当たり的なスクリプトや手動での検証に依存しがちでした。これでは、データが「負債」となり、ビジネスの意思決定を支えることはできません。

この課題を解決するために提唱されているのが、ADLC(Analytics Development Lifecycle:アナリティクス開発ライフサイクル) です。ADLCは、データ分析をソフトウェア開発(SDLC)と同様の厳格なプロセスとして捉え、生データから実行可能なビジネスインサイトに至るまでのプロセスを標準化します。

この記事では、ADLCが実現する 「信頼性」「ベロシティ(速度)」「ガバナンス」 の統合について、その戦略的な意義と具体的な8つのステージを解説します。

ADLCの戦略的意義:ガバナンスとベロシティの統合

ADLCの最大の戦略的意義は、従来の「ガバナンス(統制)とベロシティ(速度)はトレードオフ」という常識を覆す点にあります。

ADLCは、分析システムを単なるデータ集計スクリプトではなく、厳格なテスト、バージョン管理、CI/CDが適用される「ソフトウェアシステム」 として扱うというパラダイムシフトを組織にもたらします。

- SDLCからの借用: バージョン管理、体系的なレビュー、標準化されたコード、CI/CDといった成功したソフトウェア開発のプラクティスを取り入れます。

- 本質的な違い: SDLCが比較的安定した要件に基づいて線形に進むのに対し、ADLCはデータインサイトによって要件自体が進化する動的なプロセスです。そのため、高い柔軟性と迅速な反復能力が求められます。

成熟したADLCは、以下の3つの要素を統合することで実現されます。

- プロセス: 計画から反復までの8つの明確な管理ステージ。

- 組織: データエンジニアリングと分析のギャップを埋めるアナリティクスエンジニア(AE) を中心とした役割分担。

- テクノロジー: CI/CDおよびオブザーバビリティを組み込んだモダンデータスタック(MDS) の採用。

この統合により、データ資産の正確性と監査可能性が保証され、高い信頼性を維持しながらデプロイメント頻度を増やす(ベロシティを加速させる) ことが可能となります。

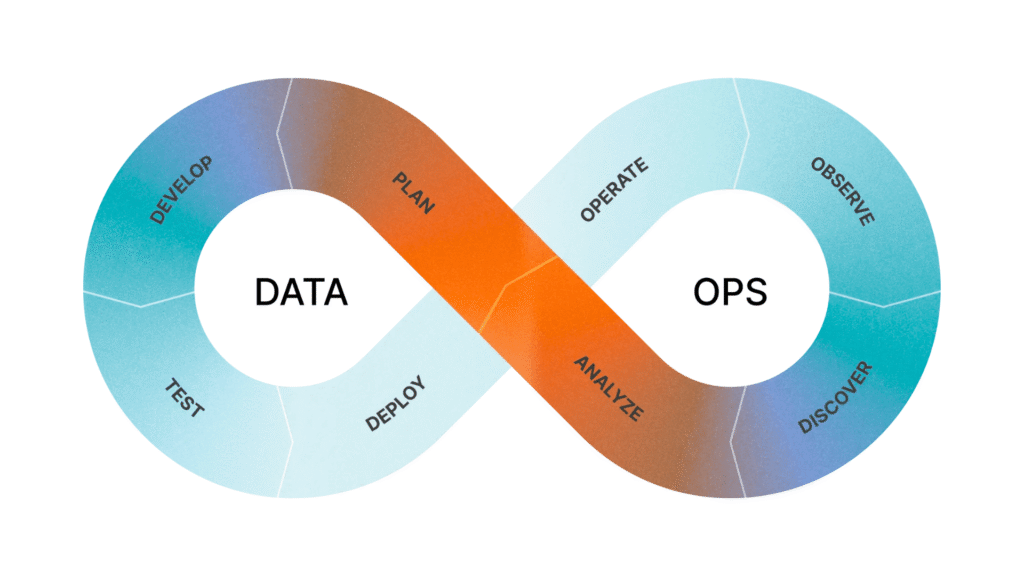

2. ADLCの8つの主要ステージ:反復的なデータ製品開発モデル

ADLCは、単なる線形的な手順ではなく、継続的なフィードバックループとして機能します。ここでは、プランニングから継続的な改善に至るまでの8つの主要なステージを詳述します。

| ステージ | 焦点(目的) | 主な活動 |

|---|---|---|

| 1. 計画 (Plan) | ビジネス価値と目標の明確化 | 要件収集、具体的なビジネス質問の定義、テスト計画の策定 |

| 2. 開発 (Develop) | 信頼性の高い分析資産の構築 | データ探索、データモデリング、コードレビュー(コードファースト原則) |

| 3. テスト (Test) | 変更の正確性の検証 | CIパイプラインによる自動テスト(ユニットテスト、データテスト)の実行 |

| 4. デプロイ (Deploy) | 検証済みコードの本番環境への移行 | ソースコードマージに基づく自動デプロイ、複数環境での管理 |

| 5. 操作 (Operate) | 安定稼働の維持 | スケジュールされたジョブの実行、リソース管理、SLA確保 |

| 6. 監視 (Observe) | データの健全性確保 | 継続的なデータテスト、データオブザーバビリティによる異常検知 |

| 7. 発見/ 8. 分析 (Discover/Analyze) | インサイトの抽出と意思決定 | 定量的な出力の解釈、意思決定を促進する分析の実行。分析結果や品質問題のフィードバック収集、次期計画へのインプット |

ADLCを実現する組織構造とテクノロジー

ADLCの成功は、適切な役割分担とモダンデータスタックの活用によって支えられます。

ADLCの成熟において、アナリティクスエンジニア(AE)の役割は、データエンジニアリング(DE)とデータ分析(DA)の間のギャップを埋めるブリッジング機能として極めて重要です。

| 役割 | 責任範囲 |

|---|---|

| データエンジニア (DE) | コアなデータインフラの構築と維持、データウェアハウス管理。(技術的アーキテクチャの信頼性) |

| アナリティクスエンジニア (AE) | データ変換とモデリング、再利用可能なデータ資産の構築、テストの適用。(データ資産の信頼性) |

| データアナリスト (DA) | ビジネス要件の収集、インサイトの抽出、意思決定の促進。(ビジネス価値の創出) |

AEは、dbtなどの標準化されたツールを使用し、データエンジニアが整備した生データを、アナリストが信頼して使える形式(データプロダクト)へと変換する責任を負います。

ADLCが求める厳密な要件は、以下のモダンデータスタック(MDS) によって技術的に実現されます。

| 機能領域 | 代表的なツール例 | ADLCへの貢献 |

|---|---|---|

| データ変換 | dbt (Data Build Tool) | 分析コードのバージョン管理、テスト、CI/CDの適用。ADLCの中心 |

| データウェアハウジング | Snowflake, BigQueryなど | 任意のデータサイズに対応するスケーラビリティを提供 |

| 監視 (Observe) | Monte Carlo, Elementaryなど | 本番データの継続的な品質監視とエラー予測(レジリエンスの確保) |

| デプロイ/操作 | dbt Cloud, Apache Airflowなど | 複雑なパイプラインのスケジューリングと、自動デプロイを実現 |

まとめ:ADLCの適用は戦略的投資である

アナリティクス開発ライフサイクル(ADLC)は、現代の企業がデータインサイトをミッションクリティカルな成果物として扱い、信頼性の高い、スケーラブルな方法で提供するために不可欠な運用モデルです。

ADLCの導入は、初期段階でコードレビューやテストの記述といった体系的なプロセス定義のオーバーヘッドを要求します。しかし、これは短期的なコストではなく、長期的なデータ信頼性、レジリエンス、およびスケーラブルな開発速度を確保するための不可欠な戦略的投資として捉えるべきです。

手動プロセスから脱却し、ガバナンスを自動化することで、チームは信頼性を維持しながら、より頻繁に、より速くデータ製品をリリースできるようになるでしょう。

この記事が役に立ったと感じたら、ぜひX(@aelabdata)をフォローください!日々のアナリティクスエンジニアとしての学びや、記事の更新情報を発信しています。